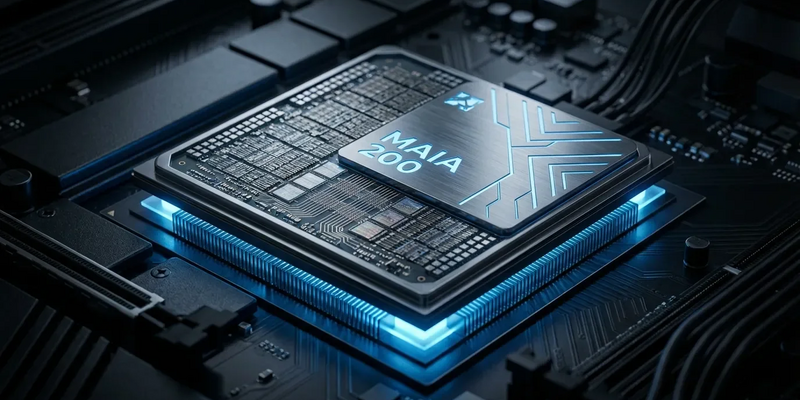

Microsofts Maia 200: Neuer Super-Chip soll KI-Kosten drücken

27.01.2026 - 18:52:13Microsoft setzt mit einem eigenen Hochleistungs-Chip einen neuen Maßstab im Wettrennen um die KI-Infrastruktur. Der Maia 200 soll die Ausführung von KI-Modellen deutlich beschleunigen und verbilligen – ein strategischer Schlag gegen Konkurrenten wie Google, Amazon und vor allem NVIDIA.

Architektur für die nächste KI-Generation

Der Chip ist ein Kraftakt der Ingenieurskunst. Hergestellt im modernsten 3-Nanometer-Verfahren von TSMC, vereint er 144 Milliarden Transistoren auf kleinstem Raum. Diese Dichte ermöglicht enorme Leistung bei vergleichsweise geringem Stromverbrauch. Mit bis zu 10 PetaFLOPS in niedrigpräzisen FP4-Berechnungen ist der Accelerator speziell auf die Anforderungen großer Sprachmodelle zugeschnitten.

Ein entscheidender Faktor ist der schnelle Datentransfer. Um den Flaschenhals „Speicherbandbreite“ zu beseitigen, verfügt der Maia 200 über 216 GB Highspeed-HBM3e-Speicher mit einer Übertragungsrate von 7 TB/s. Bei einer thermischen Verlustleistung von 750 Watt kann der Chip sowohl mit Luft- als auch mit effizienterer Flüssigkühlung betrieben werden.

Passend zum Thema KI-Infrastruktur: Seit August 2024 gelten neue EU-Regeln für Künstliche Intelligenz – viele Unternehmen riskieren ohne Vorbereitung Bußgelder oder umfangreiche Dokumentationspflichten. Dieser kostenlose Umsetzungsleitfaden erklärt in verständlichen Schritten, welche Kennzeichnungen, Risikoklassen und Nachweise Ihr KI-System braucht und welche Fristen Sie beachten müssen. Ideal für Entwickler, Cloud-Anbieter und IT-Verantwortliche, die KI-Lösungen skalieren wollen. Jetzt KI-Leitfaden zur EU-Verordnung herunterladen

Effizienztreiber für die globale Azure-Cloud

Das zentrale Ziel ist wirtschaftlich: KI massentauglich machen. Microsoft gibt an, dass der Maia 200 eine 30 Prozent bessere Leistung pro Dollar als die Vorgänger-Hardware bietet und zudem 30 Prozent günstiger als andere KI-Chips am Markt sei. Da die Ausführung (Inferenz) von Modellen den Großteil der KI-Rechenkosten ausmacht, sind solche Einsparungen essenziell für Dienste wie Microsoft 365 Copilot.

Der Chip ist für extreme Skalierung ausgelegt. Über ein integriertes Ethernet-Netzwerk können bis zu 6.144 Maia-200-Acceleratoren zu einem riesigen Rechenverbund gekoppelt werden. Diese Architektur soll auch mit den wachsenden, mehreren Billionen Parameter umfassenden KI-Modellen der Zukunft Schritt halten.

Strategischer Schachzug im Hardware-Krieg

Mit dem eigenen Chip-Design folgt Microsoft dem Beispiel von Google und Amazon und reduziert die Abhängigkeit von NVIDIA. Das Unternehmen behauptet, der Maia 200 sei der leistungsstärkste Eigenbau-Chip eines Cloud-Anbieters: Er liefere dreimal so viel FP4-Leistung wie Amazons Trainium-Chip der dritten Generation und übertreffe auch Googles TPU v7 in der FP8-Performance.

Die Fokussierung auf Inferenz ist klug kalkuliert. Während das Training von Modellen eine einmalige Investition ist, findet die Ausführung milliardenfach täglich statt – und verursacht so die langfristig größten Betriebskosten. Ein darauf optimierter Chip gibt Microsoft die Möglichkeit, wettbewerbsfähigere Preise auf der Azure-Plattform anzubieten.

Bereits im Einsatz – und die Zukunft im Blick

Der Maia 200 ist bereits im US-Rechenzentrum von Microsoft in Iowa im Einsatz und betreibt dort unter anderem OpenAIs GPT-5.2-Modelle und Microsoft 365 Copilot. Weitere Stationen in Arizona und eine globale Rollout sind geplant.

Die Entwicklung markiert einen Wendepunkt. Cloud-Giganten designen zunehmend Hardware, Software und KI-Modelle als integriertes System. Um die Akzeptanz zu fördern, stellt Microsoft ein Software Development Kit (SDK) bereit. Für Unternehmen, die komplexe KI-Agenten einsetzen, wird die Nachfrage nach solch effizienter Inferenz-Hardware weiter stark steigen.

PS: Die technische Strategie eines eigenen KI-Chips ist wichtig — aber regulatorische Pflichten können den Einsatz massiv beeinflussen. Unser kostenloser Leitfaden zur EU‑KI‑Verordnung fasst praxisnah zusammen, wie Sie Ihr System richtig klassifizieren, dokumentieren und rechtssicher betreiben, damit Hardware‑Entwicklung und Cloud-Rollout nicht an Compliance scheitern. Perfekt für Unternehmen, die KI‑Infrastruktur in Produktion bringen. Kostenlosen Umsetzungsleitfaden zur KI-Verordnung sichern